Nuovi sistemi di valutazione per l’assunzione di ricercatori universitari: software per contare il numero di citazioni e dare voti alle pubblicazioni

In origine il sistema accademico valutava e selezionava i candidati ricercatori per mezzo di una commissione di concorso che leggeva e commentava pubblicamente le loro pubblicazioni, assegnando giudizi conclusivi, motivati al momento dell’esame. Oggi, in nome della massima oggettività, attraverso appositi software si contano le citazioni dei loro articoli su riviste più o meno scientifiche, fino ad arrivare a quelle sui social network.

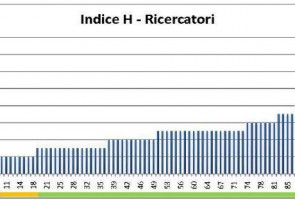

La legge dell’ex ministro dell’Istruzione Mariastella Gelmini ha cambiato la precedente modalità in risposta alle numerose polemiche sulla mancata trasparenza degli esami e dei loro risultati. Ha preso forma così un sistema di valutazione che ha abbandonato il criterio qualitativo in nome di uno quantitativo. In sostanza, si assegnano dei veri e propri voti alle pubblicazioni scientifiche, si sommano tutti quelli che riguardano ogni singolo ricercatore insieme a punteggi che considerino, ad esempio, l’età anagrafica e si stila una classifica che dovrebbe essere esatta e non interpretabile.

A questo punto però, seguendo sempre l’intento della massima trasparenza, è sorto il problema di sottrarre i valutatori dalla responsabilità di assegnare voti ai lavori degli aspiranti ricercatori, modalità che di per sé non elimina il rischio della valutazione soggettiva. Il passo successivo è stato dunque quello di misurare la popolarità degli articoli accademici contando letteralmente, per mezzo di software, il numero delle loro citazioni.

Quali sono gli esiti negativi di questo sistema? Il primo è che i software adibiti al conteggio non riescono a fare differenza tra citazioni positive e quelle negative, componendo così un “calderone” di frasi indistinte che hanno come unico comune denominatore la citazione di parole tratte dal testo pubblicato, senza valutarne però la correttezza e la validità – ad esempio sono contate come valide le citazioni interrotte e incomplete.

Il secondo problema è che, dopo averne preso consapevolezza, i ricercatori si sono adeguati al sistema di valutazione adottato e sia le pubblicazioni che le bibliografie si sono “arricchite” di autocitazioni, oltre che di citazioni incrociate tra studiosi diversi. E la situazione è peggiorata con l’entrata in scena dei social network. Un’associazione internazionale di biblioteche universitarie – la SPARC – ha infatti elaborato un ulteriore software che misura anche le citazioni su Twitter, Facebook, Linkedin, Wikipedia e vari blog, considerando utili anche i commenti.

Intanto, mentre in Europa – in particolare in Francia e Germania – gli accademici protestano contro lo strapotere della valutazione, il nostro Paese non sembra voler cambiare rotta, con il Consiglio universitario nazionale (CUN) che anzi ha tentato recentemente di approfondire il tema con una consultazione pubblica online per stabilire i parametri di scientificità delle pubblicazioni e degli altri prodotti della ricerca accademica.